Demokratisierung der KI-Technologie

Plattformen als Wege zum Modell

von Bernd Reder - 12.02.2024

Wer KI-Modelle entwickeln und testen möchte, muss nicht zwangsläufig die IT-Infrastruktur, Tools und Basismodelle im eigenen Haus vorhalten. Eine Alternative sind KI-Plattformen, beispielsweise von Anbietern wie Hugging Face, H2O, Datarobot und MosaicML und IBM (Watsonx). Nvidia bietet für solche Aufgaben AI Workbench an. Damit können Entwickler KI-Umgebungen in Form von Containern auf Linux- und Windows-Systemen einrichten, inklusive Modellen und Tools von Github. Die KI-Workloads lassen sich bei Bedarf in Cloud-Umgebungen oder die DGX-Cloud von Nvidia verschieben. Dort stehen Grafikprozessoren und weitere KI-Modelle zur Verfügung.

Auch die Datenplattformen von Databricks und MongoDB mit Services wie MongoDB Atlas können den Weg zum KI-Modell ebnen. „Unternehmen sollten darauf achten, sich nicht in die Abhängigkeit einzelner Anbieter zu begeben“, mahnt Matt Keep von MongoDB. „MongoDB Atlas Vector Search läuft daher auf AWS, Microsoft Azure und Google Cloud und arbeitet mit KI-Modellen von Bedrock AI, OpenAI, Google Vertex AI oder Hugging Face zusammen, ohne dass Entwickler auch nur eine Codezeile in ihrer Anwendung ändern müssen.“

KI-Modell via Cloud-Service

Eine weitere Nutzungsoption sind Dienste von Cloud-Serviceprovidern, und zwar nicht nur die der Hyperscaler- Mittlerweile bieten auch Provider mit Sitz in der Europäischen Union den Zugang zu KI-Diensten und Entwicklungsressourcen. „Wir sehen uns aktuell in der Rolle, KI zu demokratisieren – besonders für kleine und mittelständische Unternehmen“, sagt beispielsweise Mark Neufurth, Lead Strategist bei Ionos. „Wir verstehen uns als Partner auf Augenhöhe, der KI-Tools auch kuratiert anbieten kann, anstatt KMU auf die Suche in den Dschungel der Tools zu schicken.“

Neufurth betont einen weiterer Vorteil von EU-Anbietern für die Unternehmen: „Da die Daten in europäischen Rechenzentren gehostet werden, gehen die Kunden und Anwender sicher, dass sie Herr über ihre Daten bleiben. Dies ist insbesondere bei sensiblen Daten entscheidend.“

Für Cloud-Plattformen generell spricht, dass sie eine skalierbare Infrastruktur für KI-Modelle und entsprechende Anwendungen zur Verfügung stellen.

Balance-Akt: Der in zwei bis drei Jahren in Kraft tretende EU AI Act soll die Risiken bändigen, ohne die Chancen abzuwürgen.

(Quelle: Shutterstock / AlexLMX )

Kombination von KI-Spielarten

Doch trotz des „Hype“, den GenAI ausgelöst hat, wird die KI-Welt auch künftig nicht nur aus diesem Ansatz bestehen: „Die klassischen KI-Anwendungsfälle sind nach wie vor wichtig, und es wird weiterhin große Investitionen in diesen Bereichen geben“, betont Mat Keep. Als Beispiel führt er die KI-gestützte Verwaltung von Lagerbeständen an. Auch die Sprachsteuerung von Edge-Systemen in der Industrie und im Home-Automation-Bereich erfordere nicht zwangsläufig Generative AI.

Auch Nils Nörmann von IBM Technology plädiert für eine differenzierte Sichtweise: „Generative KI kann für viele Anwendungsfälle sehr gute Ergebnisse liefern. Die hohen Betriebskosten können sie allerdings für manche Szenarien unwirtschaftlich machen.“ Daher sei Conversational AI, die sich auf die Interaktionen von Mensch und Maschine konzentriere, in einigen Fällen die bessere Alternative. „Conversational AI analysiert und erkennt Intents und gleicht sie mit vortrainierten Antworten ab, kann aber im Gegensatz zu generativer KI nicht ‚kreativ‘ werden und neue Antworten generieren“, so der Fachmann.

In der Praxis werden sich daher Einsatzszenarien entwickeln, in denen beide KI-Ansätze zum Tragen kommen, zum Beispiel bei der Automatisierung von Kundenservice-Anfragen mit Hilfe von Chatbots.

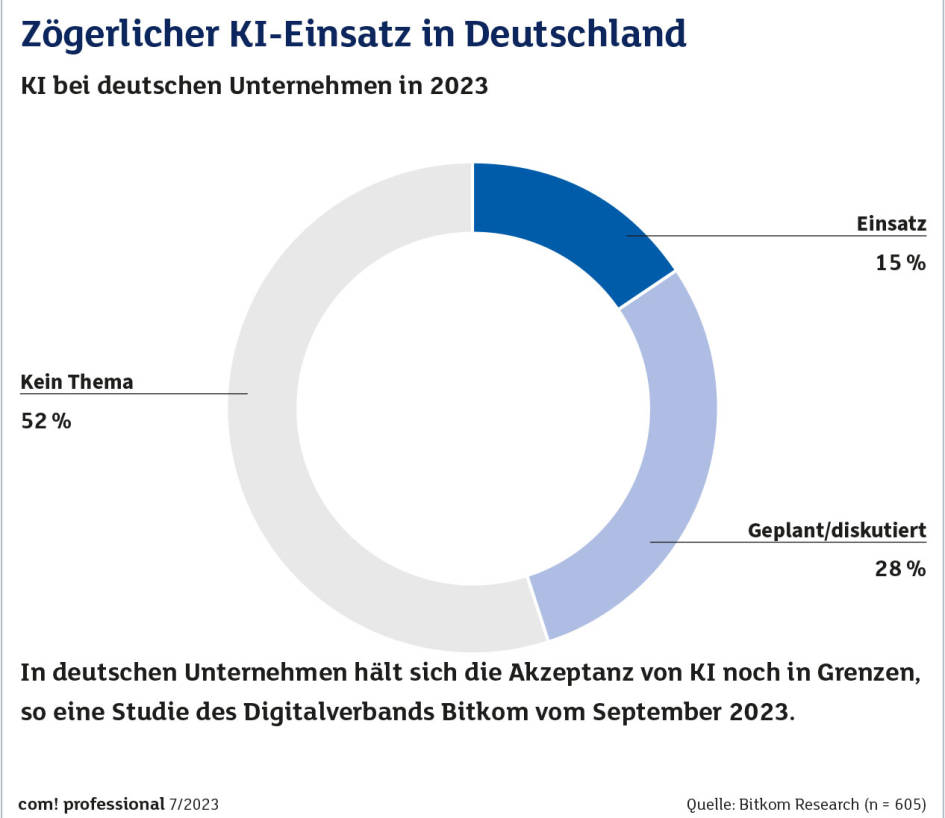

KI-Einsatz

(Quelle: Bitkom Research)

Heiße KI-Trends

Zum Abschluss ein Blick auf die Trends, die bei KI allgemein und GenAI im Besonderen derzeit an Bedeutung gewinnen. Zu diesen zählt Retrieval Augmented Generation (RAG). Dieser Ansatz kombiniert KI-Modelle, die auf Abfragen basieren, mit Generative AI. Die Abfragen extrahieren Wissen aus vorhandenen Quellen wie Datenbanken, Dokumenten, Web-Seiten und Blogs. Unternehmen können dafür außerdem eigene, geschäftsspezifische Informationen verwenden. In die Antworten von GenAI-Systemen fließen dadurch verstärkt aktuelle Informationen ein. Dies reduziert die Gefahr, dass eine generative KI-Anwendung falsche Antworten „halluziniert“.

Ein weiterer Vorteil ist, dass Nutzer das KI-Modell nicht permanent mit neuen Daten trainieren und dessen Parameter ständig neu justieren müssen. Zu den Plattformen, die RAG-Funktionen bereitstellen, zählen IBM Watsonx, Cohesity, Microsoft Azure OpenAI und Google in Verbindung mit dem Vertex-Palm-2-LLM.

Noch einen Schritt weiter als RAG gehen KI-basierte autonome Agenten. Auch ihre Grundlage sind große Sprachmodelle. Solche Agenten sollen in der Lage sein, eigenständig Aufgaben zu erfüllen – ähnlich wie ein Mensch. Dazu zählen Telefonate führen, E-Mails versenden und Aufgabenlisten erstellen, inklusive Erinnerungen. Erste Feldversuche mit solchen KI-Technologien laufen bereits, etwa mit AutoGPT von OpenAI und Jarvis von Meta.