Superintelligenten Systemen fehlt der gesunde Menschenverstand

Ohne Common Sense

von Jens Stark - 27.05.2019

Nach Meinung von Roman Yampolskiy werden superintelligente Machinen nicht über etwas wie gesunden Menschenverstand verfügen

(Quelle: Jens Stark/NMGZ )

Diese Probleme zu erkennen und gegebenenfalls einzudämmen, sei denn auch Hauptschwerpunkt seiner Forschung, so Yampolskiy. "Dabei haben wir zunächst einmal eine Taxonomie entwickelt, um aufzeigen zu können, wo die Fehlentwicklungen auftreten können. Dazu gehören beispielsweise Softwarebugs oder Fehler im Software-Engineering", führt der Forscher aus und verweist auf eine weitere Fehlerquelle im Rahmen des Maschine Learnings. Diesen Systemen könne nämlich auch etwas Falsches beigebracht werden, mit verheerenden Folgen.

Besonderes Augenmerk legt Yampolskiy und sein Team von Wissenschaftler, in die Möglichkeit, dass die superintelligenten Systeme in falsche Hände geraten könnten. Es sei fast nicht zu verhindern, dass sich auch Cyberkriminelle dieser Rechner für ihre Machenschaften bemächtigten. Am meisten Angst hat Yampolskiy davor, dass auch KI künftig als Service angeboten werden wird, so wie es heute schon Software as a Service oder Infrastructure as a Service gibt. "Mit AI als Service kann faktisch jeder zum Übeltäter werden", meint er. "Was sie sich an Kriminalität und Vandalismus vorstellen können, ist dann möglich", so seine Befürchtung. "Ich möchte hier aber nicht zu sehr ins Detail gehen, um Sie nicht auf falsche Ideen zu bringen".

Deep Fakes als erste Anwendung

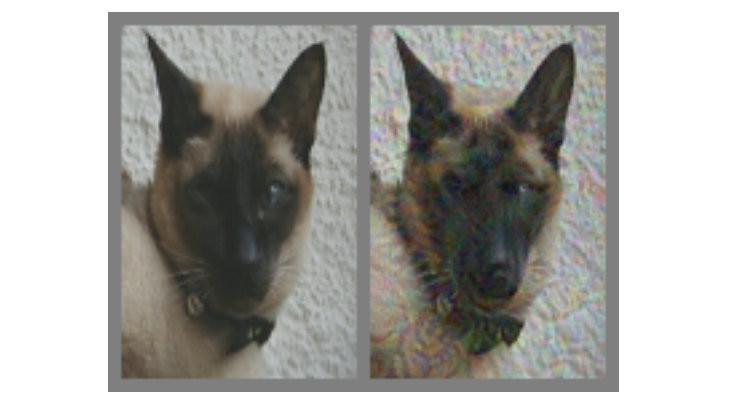

Katze oder Hund? Nur wenige veränderte Pixel können den Betrachter an der Nase herumführen.

(Quelle: Google Brain )

Daneben sei es heute möglich, Gesichtserkennungssysteme aufs Glatteis zu führen. Yampolskiy präsentierte zwei Bilder, die sich nur um wenige Pixel unterscheiden, aber eine Maschine dazu bringen könnten, das Geschlecht des Abgebildeten oder der Abgebildeten falsch zu interpretieren. Auch Menschen könnten mit geringen Veränderungen an der Foto getäuscht werden. Hier gibt es bereits Versuche und Forschungen, bei denen das Bild einer Katze geringfügig geändert wird, so dass es Vielen wie das Konterfei eines Hundes vorkommt.