AI made in Europe

Europäisches Large Language Model

von

Bernhard

Lauer - 13.02.2024

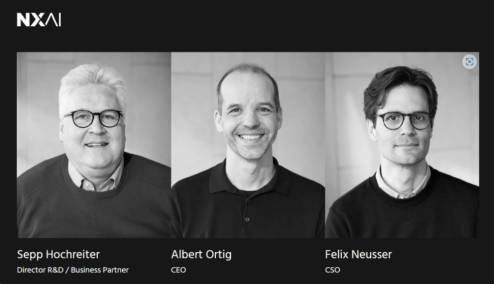

Foto: nx-ai.com

KI-Pionier Sepp Hochreiter, Company Builder Netural X sowie PIERER Digital Holding haben die NXAI GmbH gegründet, um europäische KI-Spitzenforschung zu fördern und KI-Lösungen für den internationalen Markt zu entwickeln.

Erster Fokus ist die Weiterentwicklung der neuen europäischen Large Language Model Technologie xLSTM. Dabei ist sowohl die gesamte Technologie als auch der xLSTM-Algorithmus eine vollständig europäische Entwicklung. Zwischen der Johannes Kepler Universität Linz und NXAI wurde eine Forschungskooperation vereinbart, um bisherigen Erkenntnissen rund um xLSTM zur Marktreife zu verhelfen.

Mit der im Dezember 2023 gegründeten NXAI soll ein neues Zentrum für KI-Forschung und -Produktentwicklung im Herzen Europas entstehen, an dem der Grundstein für europäische KI-Anwendungen auf wettbewerbsfähigem, globalen Niveau gelegt und ein eigenes Large Language Model gebaut wird.

Von Beginn an geht es um Large Language Models (LLM) und den von Hochreiter entwickelten xLSTM-Algorithmus. Erste Ergebnisse zeigen, dass xLSTM effizienter (mit weniger Rechenkapazität), schneller und vor allem besser (höhere Genauigkeit) arbeitet bisherige LLMs. Insbesondere, so NXAI, versteht xLSTM die Semantik von Texten besser als die bisherigen LLMs und kann dadurch komplizierte Texte verstehen und generieren. Darüber hinaus will NXAI zukünftig weltweit führende algorithmische Methoden im Bereich Deep Learning erforschen, zum Beispiel zur Beschleunigung von Simulationen komplexer dynamischer Systeme.

KI-Vordenker Sepp Hochreiter legte den Grundstein bereits 1991 und erfand die LSTM (Long Short Term Memory)-Technologie. Damit ebnete er den Weg zur heutigen Form der Künstlichen Intelligenz. Die Technologie war bis 2017 die führende Methode in der Sprachverarbeitung und der Textanalyse und wurde bis heute milliardenfach in Smartphones eingesetzt. 2023 gelang dem KI-Experten mit xLSTM ein weiterer Durchbruch.

Aktuelle Large Language Modelle basieren auf den sogenannten Transformermodellen. Diese benötigen im laufenden Betrieb sehr hohe Rechenleistungen, wenn der Text lang ist. Die Transformer-Berechnungen steigen somit quadratisch mit der Textlänge. Im Gegensatz dazu steigen die xLSTM-Berechnungen nur linear mit der Textlänge und brauchen im laufenden Betrieb weniger Rechenleistung. Das ist ein großer Vorteil, da komplexe Aufgaben viel mehr Text sowohl zur Aufgabenbeschreibung als auch zur Lösung brauchen. Damit werden, so NXAI, mit xLSTM industrielle Anwendungen möglich, für die Transformermodelle zu langsam sind.

xLSTM besitzt, wie auch Transformermodelle, einen phonetischen Speicher. Allerdings ist der Algorithmus mit einer weiteren Komponente ausgestattet, die zu einer größeren Ähnlichkeit mit dem menschlichen verbalen Arbeitsgedächtnis führt. Dadurch ist der xLSTM-Algorithmus um ein vielfaches leistungsstärker. Mit ihrer gesteigerten Effizienz und Leistung in der Verarbeitung von Texten soll die xLSTM-Technologie einen neuen Standard in der KI-Sprachverarbeitung setzen.

Weitere Informationen finden Sie unter nx-ai.com.