Auf dem richtigen Weg zu guten Daten

So bereinigen Sie Ihre Daten

von Klaus Manhart - 06.03.2019

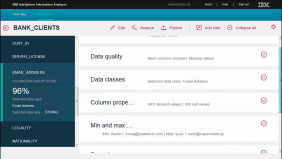

Ist das Kind in den Brunnen gefallen und die Daten sind von minderer Qualität oder wurden Daten in schlechtem Zustand aus Fremdquellen bezogen, dann kommt man um eine Bereinigung nicht herum. Grundsätzlich sollten die Bereinigungsprozesse möglichst bereits vor dem Einspeisen der Daten ins Data Warehouse erfolgen.

Die Datenbereinigung - im Fachjargon Data Cleansing genannt - wird aufgrund der großen Datenbestände heute kaum mehr manuell durchgeführt. Stattdessen erledigen Algorithmen diese Aufgabe: Sie überprüfen Datentypen, konvertieren sie und erkennen und vervollständigen lückenhafte Daten. Software übernimmt auch das Bereinigen von Dubletten. Gelöscht werden dürfen Dubletten nicht, denn würde dies geschehen, könnte möglicherweise die richtige, nur einen Tippfehler enthaltende Adresse entfernt werden.

Die Korrektur geschieht im Rahmen eines Regelwerks. Dort wird genau definiert, nach welcher Priorität zwei scheinbar identische Datensätze verändert werden. Wurde beispielsweise eine Dublette identifiziert, bei der mit Ausnahme der Telefonnummer alle Adressbestandteile identisch sind, muss klar sein, welche Nummer übernommen werden soll.

Nicht alle Entscheidungen sollte man aber den Tools überlassen. Es gibt einige Bereiche, in denen besser der Mensch eingreift. Dies gilt besonders für Fachabteilungen, in denen Datenqualität sehr wichtig ist. Hier lassen sich Grenzwerte festlegen und beispielsweise Maximal- und Minimalwerte definieren, wann ein Tool entscheidet und ab wann ein Mensch zugeschaltet wird.

Dazu ein Beispiel: Wenn das Tool mit einer Wahrscheinlichkeit von mindestens 80 Prozent errechnet, dass ein Eintrag ein Duplikat ist, darf es diesen selbstständig als solches behandeln. Ist der Minimumwert 20 Prozent und geringer, ist es automatisch kein Duplikat. Alles, was zwischen 20 und 80 Prozent liegt, sollte sich dann ein Mitarbeiter ansehen.

Für eine optimale Datenqualität zu sorgen ist keine singuläre Herausforderung, sondern ein iterativer Prozess, der fest im Unternehmen verankert werden muss. Weil sich dieser Prozess immer wieder wiederholt, spricht man auch vom Closed-Loop-Prinzip. Gemeint ist damit, ein Datenqualitäts-Managementsystem aufzubauen, das saubere Datensätze auf Dauer sicherstellt.

Hierfür ist es allerdings unerlässlich, wiederkehrende Kontrollen und Bereinigungen einzuplanen. Auch zu diesem Zweck kann Software genutzt werden.