Predictive Analytics schlagen das Bauchgefühl

Vier neue Aspekte der Predictive Analytics

von Thomas Hafen - 05.02.2016

Die angewandten Predictive-Analytics-Verfahren wie multivariate Statistik, neuronale Netze oder maschinelles Lernen sind nicht neu. Sie werden schon seit vielen Jahren in der Forschung, aber auch in der Wirtschaft eingesetzt. Neu in Predictive Analytics sind vor allem vier Aspekte:

- Demokratisierung der Verfahren:

Wie im Bereich Business Intelligence werden auch die Prognosemodelle von Predictive Analytics immer leichter zugänglich. Grafische Bedienoberflächen ersetzen kommandozeilenbasierte Programmierschnittstellen und erlauben es, Analysen per Drag and Drop zusammenzustellen. Cloud-Angebote erleichtern außerdem den Zugang zu fortgeschrittenen Analysemethoden, ohne vorab investieren und komplexe Systeme installieren zu müssen. „Insbesondere im Bereich Labor sehe ich aufgrund der Pay-as-you-go-Angebote, der häufigen Aktualisierungen und der Möglichkeiten zur Skalierung Cloud-Werkzeuge auf dem Vormarsch“, sagt Artus Krohn-Grimberghe, Chief Data Scientist bei der pmOne Analytics GmbH, einer 2015 gegründeten Tochter der pmOne AG, die neben Beratungsleistungen auch eigene Algorithmen für fortgeschrittene Analysen entwickeln und anbieten will.

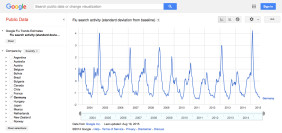

Predictive Analytics im Einsatz: Auf Basis von über 140 Suchbegriffen kann Google Grippewellen tagesgenau vorhersagen.

Predictive Analytics im Einsatz: Auf Basis von über 140 Suchbegriffen kann Google Grippewellen tagesgenau vorhersagen.

- Auswertung großer Datenmengen: Durch Big-Data-Analyseverfahren lassen sich Vorhersagen auf Basis großer Mengen unstrukturierter Daten treffen. „Durch die aktuelle Popularität des Begriffs Big Data ist das Interesse in allen Branchen stark gewachsen, Daten zu nutzen, um wertschöpfende Informationen zu generieren“, sagt Nicole Tschauder, Business Expert Analytics bei SAS Deutschland.

- Vernetzung verschiedenster Informationen: „Wo man früher eine Datenbank eingesetzt hat, nutzt man heute viele verschiedene Datenquellen“, erläutert Jakob Rehermann, Geschäftsführer des Berliner Software-Unternehmens Datapine, das seit vier Jahren eine einfach zu bedienende Software-as-a-Service-basierte Business-Intelligence-Lösung für kleine und mittlere Unternehmen entwickelt und ab April auch ein Modul zur Erstellung von Vorhersagen anbieten will.

- Interne und externe Quellen: Während klassische Prognoseverfahren hauptsächlich auf intern erhobenen Daten wie Absatzzahlen oder Einkaufspreisen beruhen, setzen heute viele Anwendungsfälle auf eine Kombination interner Informationen mit externen Angeboten wie Wettervorhersagen, demografischen Entwicklungen, Verkehrsströmen oder auch So-cial-Media-Daten. „Je mehr Informationsquellen ich habe, um so runder wird mein Bild vom Kunden“, sagt Dominik Claßen, Sales Engineering Director EMEA & APAC bei Pentaho. Durch die Vernetzung von Maschinen und internetfähigen Alltagsgegenständen entstehen ständig neue Datenströme, die für Prognosen herangezogen werden können.

- Neue Steuerungsmöglichkeiten: „Nur zu wissen, was passieren wird, bringt ein Unternehmen nicht weiter. Entscheidend ist, was mit dem vorhergesagten Szenario getan werden muss“, so SAS-Expertin Tschauder. „Erst die Kombination von Echtzeitanalysen und automatisierten Geschäftsprozessen bringt Anwendern den Effizienzgewinn, den sie im harten internationalen Wettbewerb benötigen“, erklärt Dunja Riehemann von Blue Yonder, einem Anbieter von Predictiv-Analytics-Lösungen auf Software-as-a-Service-Basis.