Verständnis schafft Vertrauen und Akzeptanz

Erklärbare KI

von Andreas Dumont - 06.04.2020

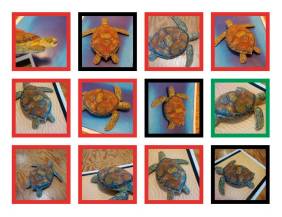

Künstliche Intelligenz von Google irrt sich: Die rot umrandeten Schildkröten hält die Bilderkennungs-KI für Gewehre.

(Quelle: LabSIX/MIT)

Nachdem Google den Algorithmus für den PageRank, einen besonders wichtigen Indikator für das Google-Ranking von Webseiten, veröffentlicht hatte, haben viele das ausgenutzt, um sich einen höheren Rank zu ergaunern. Außerdem wusste die Konkurrenz sogleich, wie sie die eigenen Suchmaschinen verbessern konnte.

Konstantin Greger betont: „Künstliche Intelligenz und Machine Learning wecken die Erwartung, dass Maschinen dem Menschen durch automatisierte Entscheidungen zu besseren Erkenntnissen verhelfen. Entscheider stellen sich aber immer häufiger die Frage: Wie können wir sicherstellen, dass automatische Empfehlungen und Modelle vertrauenswürdig sind?“ Die Algorithmen und Logiken, auf denen Entscheidungen und Empfehlungen beruhen, seien bei vielen Machine-Learning-Anwendungen nicht nachvollziehbar. Explainable AI (XAI) solle dabei helfen, diese Prozesse transparenter zu machen.

Julian Mehne definiert es so: „Explainable AI beschreibt eine Erwartungshaltung, zu verstehen, wie ein KI-Modell funktioniert, oder zumindest die Möglichkeit, eine getroffene Entscheidung nachträglich logisch nachvollziehen zu können.“

„Ein Beispiel für XAI ist Common-Sense-Reasoning bei der natürlichen Sprachverarbeitung“, sagt Kathy Baxter. „Zwar sehen wir große Fortschritte bei trainierten Sprachmodellen. Jedoch verfügen diese Systeme nicht über das intuitive, allgemeine Verständnis und die Zusammenhänge der realen Welt, die für einen Menschen selbstverständlich sind und gemeinhin als Common Sense, also gesunder Menschenverstand beschrieben werden. Bei Salesforce Research wurden deshalb Erklärmodelle genutzt, um dieses Common-Sense-Reasoning in ein Deep-Learning-Modell zu integrieren. Dabei wurde nachgewiesen, dass das Verfahren die Genauigkeit der zuvor NLP-basierten Vorhersagen um 10 Prozent steigert.“ Auf diese Weise trage Explainable AI nicht nur zum Vertrauen der Anwender, sondern auch zu einer besseren Leistungsfähigkeit der Technologien an sich bei.