Quantencomputer

Quantensprung im Super-Computing

von

Anna

Kobylinska - 11.04.2017

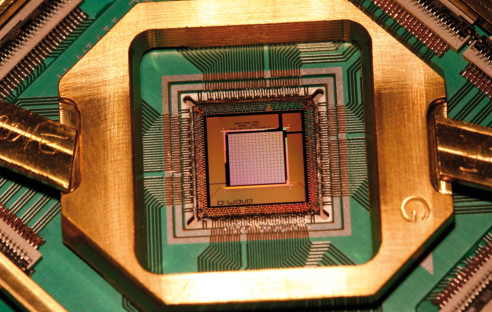

Foto: Foto: D-Wave

Quantencomputer sind keine Science-Fiction mehr, sondern stehen vor der Praxisreife. com! professional zeigt, welche Möglichkeiten aber auch Probleme sich aus der Technologie ergeben.

Big-Data-Analysen, Kryptografie oder das Internet der Dinge (IoT) – der Bedarf an massiver Rechenleistung wächst explosionsartig. Konventionelle Computer halten mit diesen steigenden Anforderungen längst nicht mehr Schritt. Selbst das High-Performance-Computing mit den stärksten Rechnern unserer Tage, den Supercomputern, stößt an physikalisch bedingte Grenzen.

Abhilfe schaffen sollen sogenannte Quantencomputer. Lange Zeit nur ein theoretisches Konzept, haben sie mittlerweile Praxisreife erreicht. Staaten wie die USA und China liefern sich derzeit ein Wettrennen in der Entwicklung der Quantencomputer. Und auch die Europäische Union hat kürzlich ein Milliardenprogramm aufgelegt, um auf diesem Feld nicht ins Hintertreffen zu geraten.

Die Grenzen des Siliziums

Seit Erfindung integrierter Schaltkreise für konventionelle Chips auf Silizium-Basis galt das Moore’sche Gesetz als die Richtschnur der Branche. Diese Faustregel besagt, dass sich die Anzahl von Transistoren in einem Schaltkreis bei gleichbleibenden Fertigungskosten ungefähr alle zwei Jahre verdoppelt. Hinzu kommt Dennards Gesetz, demzufolge die Verkleinerung des grundlegenden Bauelements in einem solchen Schaltkreis mit einer niedrigeren Stromspannung einhergeht und sich daher bei gleichbleibendem Stromverbrauch eine höhere Taktfrequenz erzielen lässt. Obwohl die Transistoren vorerst noch schrumpfen, ist das Ende der Fahnenstange bereits in Sicht. Von heute 12 bis 14 Nanometer (nm) sollen sie bis 2022 auf 0,2 nm schrumpfen. Kleiner geht’s nicht.

Die gegenüber PCs und Servern drastisch gesteigerte Rechen-Power der High-Performance-Rechner wiederum kommt im Wesentlichen zustande, weil einfach Tausende Prozessoren kombiniert werden. In der aktuellen Nummer eins der Supercomputer, dem chinesischen Sunway TaihuLight, arbeiten zum Beispiel 40.960 Prozessoren, die 93 Petaflops (Billiarden Berechnungen pro Sekunde) schaffen. Aber der Trick, immer mehr CPUs zu nehmen, bringt irgendwann nichts mehr oder wird mit Nebenwirkungen wie einem extrem hohen Energieverbrauch erkauft. Der Sunway TaihuLight ist zwar dreimal energieeffizienter als sein Vorgänger, verbraucht unter Volllast aber immer noch 15,37 Megawatt, ungefähr so viel wie 1000 Haushalte.

Die Physik der Quantenrechner

Auf der Suche nach Alternativen zur herkömmlichen Technik haben die IT-Firmen die Quantenphysik entdeckt. Dieser Zweig der Physik beschäftigt sich vor allem mit subatomaren Eigenschaften und Effekten. Gelingt es, diese Effekte für Rechenoperationen in Computern zu nutzen, lässt sich die Rechenkraft dramatisch erhöhen. Die Quantencomputer rechnen nämlich mit sogenannten Quantenbits (Qubits) anstelle von gewöhnlichen Bits. Die Qubits können beliebige Werte zwischen 0 und 1 annehmen, im Unterschied zur konventionellen Elektronik, die nur mit den beiden Werten 0 und 1 hantieren kann. Grundlagen der Qubits ist der physikalische Effekt, dass sich quantenmechanische Wellen ähnlich wie Wasserwellen überlagern können (quantum superposition).

Ein weiterer wichtiger Quanteneffekt ist die Verschränkung zweier Teilchen: Damit ist gemeint, dass sich Teilchenpaare erzeugen lassen, bei denen die Messung eines Teilchens die Eigenschaft des anderen Teilchens festlegt, obwohl die beiden weit voneinander entfernt sind und keine Signale zwischen ihnen ausgetauscht werden.