Machine Learning und der Datenschutz

Anonymisierungstechniken

von Behrang Raji - 31.08.2020

Als sowohl wettbewerbs- als auch datenschutzfreundliche Lösung werden neue Anonymisierungstechniken erwartungsvoll gefeiert, die die sich vergrößernde Kluft schließen sollen. Die DSGVO stellt im Erwägungsgrund 26 klar, dass die Verordnung und ihr umfangreicher Pflichtenkatalog keine Anwendung finden, sofern anonyme Daten verwendet werden. Wenn jedoch ohne unverhältnismäßigen Aufwand der Personenbezug wiederhergestellt werden kann, handelt es sich nur um eine Pseudonymisierung.

Juristisch unterscheidet man zwei Anonymisierungsformen: Bei der klassischen Form besteht objektiv eine Unmöglichkeit der De-Identifizierung, bei der anderen würde die De-Identifizierung einen unverhältnismäßigen Aufwand erfordern. Angesichts der enormen Rechenkapazitäten von KI-Systemen stellt sich allerdings die Frage, was noch als unverhältnismäßiger Aufwand betrachtet werden kann. Insofern wird teilweise dafür plädiert, den Begriff des personenbezogenen Datums in Zeiten von Big Data und KI neu zu denken. Gemeint ist damit, den Begriff auf de-anonymisierbare Daten auszuweiten.

Bei der klassischen Anonymisierung werden alle Identifizierungsmerkmale entfernt. Der Nachteil: Verlust der Werthaltigkeit der Daten. Daneben können etwa auch Zusammenfassungen von Daten zu statistischen Daten - abhängig vom Aggregationsniveau - anonyme Daten darstellen.

Synthetische Daten

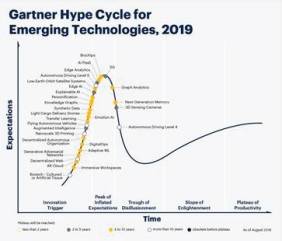

Synthetische Daten: Das Beratungshaus Gartner stuft synthetische Daten als eine „Emerging Technology“ ein.

(Quelle: Gartner)

Game Changer

Datengetriebene KI-Systeme sind vor allem in der lernenden Trainingsphase auf ausreichend Datenbestände in guter Qualität angewiesen. Synthetische Daten, so heißt es im Gutachten der Datenethikkommission 2019, können im Gegensatz zu den Daten mit Personenbezug beliebig produziert und in der Trainingsphase eingesetzt werden, etwa um ungewöhnliche Datenkonstellationen zu testen. Die Weitergabe an Dritte ist möglich, was Kollaborationen mit Geschäftspartnern erlaubt. Letzteres fördert zudem den Mittelstand, da sonst nur die bekannten Global Player in der Lage wären, KI-Systeme zu entwickeln.

Die Werthaltigkeit bleibt bei synthetischen Daten erhalten und das System kann durch gezielte Ausmerzung von Verzerrungen insgesamt besser austariert werden, was einer Diskriminierungsvermeidung dienlich sein kann. Im Gegensatz zu klassischen Anonymisierungsverfahren, bei denen der Wert und damit die Erkenntnisse aus den Daten weitgehend verloren gehen, können solche Techniken Innovationen fördern und gleichzeitig - aus datenschutzrechtlicher Sicht - die Rechte und Freiheiten der Betroffenen schützen. Soll eine gewisse Qualität der Daten erhalten bleiben, ist meist bei klassischer Anonymisierung eine De-Identifizierung mit verhältnismäßigem Aufwand eben doch möglich, sodass es sich um Pseudonymisierung und nicht um Anonymisierung handelt.