Hintergrund

Der Weg der KI führt über neue Prozessoren

von

Klaus

Manhart - 14.01.2020

Foto: Connect World / shutterstock.com

Spezial-Chips machen KI-Anwendungen leistungsfähiger - in Rechenzentren und Endgeräten. Aber ob cloudbasiert oder On-Premise: Beides hat seine Vor- und Nachteile.

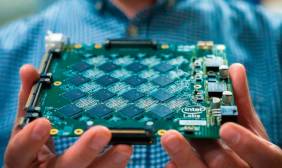

Vorbild Gehirn: Neuromorphe Chips (im Bild ein Intel-Modell) brechen komplett mit der herkömmlichen CPU-Architektur.

(Quelle: Intel)

KI als Service hat den Vorteil, dass die großen Cloud-Provider zahlreiche innovative Technologien entwickelt haben, von denen Anwender sofort profitieren. Der Einstieg ist nicht allzu schwierig und es stehen zahlreiche Tools und Services zur Verfügung. Kosten-, Effizienz- und Compliance-Gründe können allerdings dafür sprechen, KI-Anwendungen im eigenen Haus zu entwickeln.

Weil für KI Unmengen von Daten an die Cloud-Dienstleister übertragen werden müssen, können die oft schmalen Netzwerkbandbreiten und hohe Latenzen die Ausführungseffizienz blockieren. Dies zeigt sich schon beim Inferencing, besonders aber beim Trainieren von Modellen (siehe Kasten auf Seite 96). Viele Firmen wollen oder dürfen zudem die für KI-Modelle notwendigen und oft sensiblen Trainingsdaten nicht nach draußen geben. „Gerade hinsichtlich Cyberrisiken bestehen bei deutschen Unternehmen Bedenken, etwa was den Diebstahl sensibler Daten oder Algorithmen anbelangt“, betont Ralf Esser, Leiter TMT Insights Deutschland bei Deloitte. Als gravierendste Herausforderungen bei KI-Initiativen nannten die für eine Deloitte-Studie befragten deutschen Firmen an erster Stelle datenbezogene Probleme wie Datenschutz.

Die Rolle von GPUs

Es gibt also einige Gründe, eine eigene KI-Infrastruktur aufzubauen. Doch auch hier warten große Herausforderungen. Das Training der Modelle beim Machine Learning ist äußerst rechenintensiv. Server-, Storage- und Netzwerk-Infrastrukturen müssen die riesigen dafür notwendigen Datenmengen und die anspruchsvollen Machine-Learning-Verfahren bewältigen können. Ein Training auf gängiger serieller Hardware kann sehr lange dauern oder überhaupt nicht mehr in akzeptabler Zeit durchführbar sein. Werden die Berechnungen verteilt und gleichzeitig ausgeführt, reduziert sich der zeitliche Aufwand immens. Hier kommen Graphic Processing Units (GPUs) ins Spiel.

Wie sich in den letzten Jahren herausstellte, eignen sich die GPUs nicht nur für Grafikaufgaben, sondern auch für die beschleunigte Berechnung neuronaler Netze. Benötigt ein kleiner Datensatz auf einer klassischen CPU eine Trainingszeit von drei bis vier Minuten, so braucht er bei Verwendung einer GPU nur einige Sekunden. Bei Deep Learning, wo der Trainingsaufwand besonders hoch ist, können sich Trainingszeiten mit großen Datensätzen von mehreren Wochen auf wenige Tage verringern. Grafikprozessoren nehmen deshalb heute bei KI eine zentrale Rolle ein. Der Markt bietet inzwischen auch speziell für KI optimierte Grafikkarten an. Dabei können Hunderte von Recheneinheiten parallel Berechnungen durchführen und bringen es so auf eine Rechenleistung von weit über 100 TeraFLOPS. Die führenden Server-Hersteller nutzen heute oft Tesla- oder Volta-GPUs von Nvidia, um Systeme für KI- und analytische Anwendungen zu optimieren. Viele Hersteller bauen etwa in ihre x86-Server Volta-GPUs als „KI-Beschleuniger“ ein - mit nativer GPU-Unterstützung über eine direkte Verbindung zum Mainboard.