Daten trotz DSGVO ohne Einschränkung nutzen

Differential Privacy

von Klaus Manhart - 18.09.2019

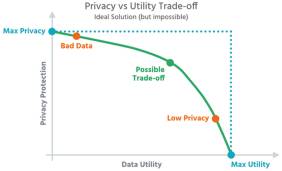

Dilemma: Je höher der Schutz der Daten (Privacy), desto geringer ist die Nutzbarkeit für hochwertige Analysen (Utility) – und umgekehrt.

(Quelle: Aircloak)

Bei Differential Privacy wird den Daten mathematisches Rauschen - falsche Daten - hinzugefügt. Dabei werden aufgrund eines Algorithmus die Merkmalsausprägungen einzelner Datensätze verändert oder weitere „unechte“ Datensätze hinzugefügt, die in die Auswertung miteinbezogen werden. Ergebnis und Verteilung werden nur geringfügig beeinträchtigt, es ist für den Anwender jedoch nicht mehr nachvollziehbar, welche der untersuchten Datensätze „echt“ sind.

Google erläutert das Verfahren auf der Seite „Wie Google Daten anonymisiert“ so: „Stellen Sie sich zum Beispiel vor, dass wir die Gesamtentwicklung bei den Suchanfragen für Grippe in einer geografischen Region messen. Um Differential Privacy zu erreichen, fügen wir den Daten Rauschen hinzu. Dabei addieren oder subtrahieren wir die Anzahl der Personen, die in einem bestimmten Viertel nach Grippe suchen. Dies wirkt sich jedoch nicht auf die Werte des Trends in der geografischen Region insgesamt aus. Die Aussagekraft von Datensätzen nimmt jedoch durch den Einsatz von Rauschen unter Umständen ab.“

Bekannt geworden ist Differential Privacy vor allem durch die Nutzung bei Apple. Der IT-Konzern bedient sich dieses Verfahrens, um sich aus einem hausgemachten Dilemma zu befreien. Einerseits erklärt sich Apple zum strengen Verfechter des Datenschutzes und Hüter der Privatsphäre seiner Nutzer. Andererseits möchte natürlich auch Apple wie Facebook oder Google von den großen Datenmengen profitieren, die auf den iPhones, iPads und Macs oder in der iCloud täglich anfallen. Mit Differential Privacy könne Apple „das Nutzererlebnis verbessern, indem das Verhalten vieler Anwender analysiert wird“, heißt es in einem Apple-Papier. Seit iOS 10 und Mac OS High Sierra ist Differential Privacy deshalb Bestandteil von Apples Betriebssystemen.

Daten synthetisieren

Ein ganz neuer Ansatz, Daten konsequent zu anonymisieren, ist die Daten-Synthetisierung. Bei dieser Methode wird eine künstliche Repräsentation der zu schützenden Originaldaten generiert, die keinerlei Rückschlüsse mehr auf Personen erlaubt. Ein Machine-Learning-Algorithmus läuft über die Kundendaten, analysiert deren Struktur und lernt durch Training die statistischen Informationen und statistischen Strukturen der Originaldaten. Mit diesem Wissen erzeugt der Algorithmus neue künstliche Daten. Diese spiegeln den gesamten Datensatz mit seinen statistischen Informationen, Strukturen und Echtdaten wider. In einer großen Datenbank-Tabelle würde der Algorithmus etwa die statistische Häufigkeitsverteilung in den einzelnen Spalten und die statistischen Korrelationen zwischen den Spalten analysieren. Sobald das Modell trainiert wurde, erzeugt die Software die synthetischen Daten mit denselben statistischen Eigenschaften. So könnte man wie bei den Originaldaten abfragen, wie hoch der Prozentsatz an männlichen Herzinfarkt-Patienten über 55 mit Übergewicht ist, und zum gleichen Ergebnis kommen.

„Diese Methode ist bereits bei Behörden und Instituten mehrerer Länder im Einsatz und wird dazu benutzt, Mikrodatensätze, also Datensätze mit Daten, die auf Individualebene beobachtet werden, zu anonymisieren“, schreiben Jörg Drechsler und Nicola Jentzsch von der Stiftung Neue Verantwortung (SNV), einer gemeinnützigen Berliner Denkfabrik. In ihrem Papier „Synthetische Daten“ verweisen sie darauf, dass die Daten-Synthetisierung bereits bei Statistikbehörden und Institutionen, aber auch in Unternehmen im Einsatz ist: „In den USA veröffentlicht das U.S. Census Bureau synthetisierte Ströme von Berufspendlern oder Einkommensdaten und Transferleistungen. In Schottland erhalten Forscher, die mit den Daten der Scottish Longitudinal Study arbeiten wollen, synthetische Daten für ihre Analysen. In Deutschland ist das Institut für Arbeitsmarktforschung (IAB) der Vorreiter in der Synthetisierung. Dort wurde das IAB-Betriebspanel für Forschungszwecke synthetisiert.“ In Deutschland hat das Start-up Statice für dieses Verfahren eine Anonymisierungs-Software entwickelt. „Wir wollen den Unternehmen nicht nur ermöglichen, auf interessanten Daten zu arbeiten, sondern gemeinsam mit Partnern aus der Analyse neue Geschäftsmodelle entwickeln, ohne die Privatsphäre ih-rer jeweiligen Kunden zu gefährden“, erklärt Statice-CEO Sebastian Weyer.