Alle Daten im Griff haben

Virtualisierung macht Schluss mit Datensilos

von

Jürgen

Mauerer - 30.10.2019

Foto: sdecoret / shutterstock.com

Klassische Data Warehouses und Data Lakes erfüllen nicht mehr die nötigen Anforderungen. Abhilfe kann eine Datenvirtualisierung schaffen.

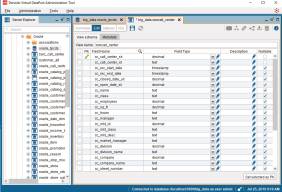

Konsistent über Datensilos hinweg: Metadaten spielen eine wichtige Rolle beim Sortieren, Filtern und Suchen von Daten.

(Quelle: Denodo)

Dazu müssen Firmen die vorhandenen, gigantischen Datenmengen allerdings zuerst erschließen und aufbereiten. Hier sieht es im deutschsprachigen Raum nicht so gut aus. Das zeigen die

Ergebnisse der aktuellen „biMA“-Studie von Sopra Steria Consulting. Demnach gibt die Hälfte aller befragten Unternehmen (49 Prozent) an, dass ihre Daten für Analysen unvollständig, veraltet oder widersprüchlich seien. Neben der mangelhaften Datenqualität stellt auch die fehlende Integration von Daten aus unterschiedlichsten Datenquellen eine Hürde dar.

Ergebnisse der aktuellen „biMA“-Studie von Sopra Steria Consulting. Demnach gibt die Hälfte aller befragten Unternehmen (49 Prozent) an, dass ihre Daten für Analysen unvollständig, veraltet oder widersprüchlich seien. Neben der mangelhaften Datenqualität stellt auch die fehlende Integration von Daten aus unterschiedlichsten Datenquellen eine Hürde dar.

Zahlreiche Firmen kämpfen bei der Datenanalyse also immer noch mit den Grundlagen: Verfügbarkeit, Integration und Qualität. Datenvirtualisierung soll diese Probleme lösen. Sie fungiert als eine Art Middleware für die schnelle Bereitstellung von Daten.

Aufwand für Datenvorbereitung

Traditionelle Ansätze des Datenmanagements auf Basis von Data Warehouses oder Data Lakes wie ETL (Extract, Transform, Load), bei denen Daten für Analysen zunächst gespeichert und transformiert werden müssen, gelangen zunehmend an ihre Grenzen.

„Der Aufwand und die Kosten sind hier sehr hoch. Bevor Unternehmen die Daten nutzen können, müssen sie diese in Datenbanken laden, speichern, bearbeiten und vorbereiten“, erklärt Nick Golovin das Problem, CEO & Gründer von Data Virtuality, einem Anbieter von Software für Datenvirtualisierung. „Der Aufbau eines Data Lakes, eines zentralen Repositorys, in dem sämtliche Daten gespeichert und verwaltet werden, ist nicht trivial.“

Oft verfügen Firmen heute über Dutzende von Datenquellen, die über Rechenzentren, Cloud-Lösungen und andere Orte verteilt sind. Daher ist nicht garantiert, dass wirklich alle relevanten Daten im Data Lake landen. Der zentrale Speicherort erleichtert zwar die Erfassung von Daten und bietet eine hohe Rechenleistung, aber die Herausforderungen an Verfügbarkeit, Aufbereitung und Integration der Daten bleiben bestehen. Denn es reicht nicht, Daten einfach in ihrer Rohform zu speichern.

Unternehmen müssen eine ausufernde Vielfalt von Datentypen und Formaten aggregieren, validieren, mit Metadaten versehen, normalisieren oder verknüpfen, um sie in möglichst optimaler Qualität für analytische und andere Zwecke einsetzen zu können. Das kostet enorm viel Zeit. Studien zeigen, dass Datenexperten bis zu 80 Prozent ihrer Zeit mit entsprechenden Aufgaben beschäftigt sind. Einen Ausweg und die Lösung des Problems verspricht die Datenvirtualisierung.