High Performance Computing in der Cloud

Beispiel: 3D-Bilder

von Oliver Schonschek - 10.09.2019

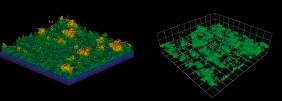

Eine weitere HPC-Anwendung sind aufwendige Videoproduktionen wie „Die Biene Maja – Die Honigspiele“ der in München ansässigen Studios 100 Media und B Animation in Koproduktion mit dem ZDF. Für die Berechnung der mehr als 230.000 3D-Bilder des Films nutzte das Animationsstudio MARK13 mit Sitz in Stuttgart den Rechner Hazel Hen, den größten Supercomputer des Höchstleistungsrechenzentrums (HLRS) in Stuttgart. „Wir haben bereits für den ersten Kinofilm mit der Biene Maja 2014 auf die Rechenkapazitäten des HLRS zurückgegriffen, weil unsere internen Kapazitäten auch aus Zeitgründen nicht ausreichten“, so Holger Weiss, CEO von MARK13. „Beim zweiten Kinoabenteuer haben wir in Sachen Rendering am HLRS stark von den Erfahrungen aus dem ersten Film profitiert. Wir konnten Prozessabläufe deutlich optimieren.“

Pro Frame (Einzelbild) lag die Berechnungszeit bei etwa 45 Minuten. Bis zu 200 Bilder berechnete Hazel Hen gleichzeitig. Das Datenvolumen für die Bildberechnung betrug insgesamt 245 Terabyte, die Rechenzeit knapp sechs Monate. „Während wir 2014 die Festplatten noch händisch zum HLRS transportiert haben, musste die Biene Maja dank neuem Glasfaseranschluss dieses Mal nicht mehr mit der S-Bahn fahren“, freut sich Weiss.

(K)eine Wissenschaft für sich

Das Implementieren einer HPC-Lösung, die zu den anstehenden Projekten im Unternehmen passt, erscheint als große Herausforderung. Es geht nicht nur um Rechenleistung, sondern auch um Speicher, Datenmanagement, Vernetzung und Kühlung, um nur einige Bereiche zu nennen. Ein Zuviel an Ressourcen würde die Kosten in die Höhe schnellen lassen. Zu stark eingeschränkte Ressourcen verringern die Zeit- und Leistungsvorteile von HPC.

Trotzdem ist HPC nicht nur etwas für Wissenschaft und Forschung, für Universitäten, die mit modernen Rechenzentren und ausgewiesenen IT-Experten ausgestattet sind: Die meisten Unternehmen können von der Analyse großer Datenmengen (Big Data) und der Einführung von Künstlicher Intelligenz (KI) profitieren und damit von HPC als einer der technischen Grundlagen. Das gilt über Großunternehmen hinaus auch für kleine und mittlere Betriebe.

Den Unternehmen kommt dabei die Cloud zu Hilfe: HPC muss nicht als On-Premise-Lösung betrieben werden, es gibt HPC-Services aus der Cloud, wodurch die Kosten für das Hochleistungsrechnen und die internen Aufwände für die Administration und den Betrieb deutlich gesenkt werden können. Ebenso können bei HPC-Cloud-Diensten die Ressourcen an den tatsächlichen aktuellen Bedarf angepasst werden. Als Unternehmen muss man sich keine dauerhafte HPC-Infrastruktur aufbauen, nur weil man beispielsweise für eine Produktentwicklung schnellere, realitätsnahe Simulationen einsetzen will.