Case-Study

Deutsche Börse macht sich fit für Big Data

von

Hartmut

Wiehr - 28.12.2017

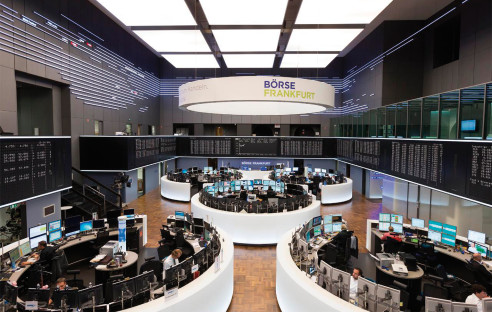

Foto: Deutsche Börse

Ohne Daten läuft an den Börsen nichts mehr. Dafür braucht es die richtige Technik. Die Deutsche Börse in Frankfurt setzt auf Big-Data-Technologie zur effizienten Datenverarbeitung.

Die Deutsche Börse organisiert Märkte für Investoren, die Kapital anlegen, und für Unternehmen, die Kapital aufnehmen. An diesen Märkten kaufen und verkaufen professionelle Händler Aktien, Derivate und andere Finanzinstrumente nach klaren Regeln und unter strenger Aufsicht. Der Service reicht von der überwachten Ausführung der Handelsaufträge über die Verrechnung, Abwicklung und Verwahrung der Wertpapiere im Nachhandel bis zur elektronischen Infrastruktur und der Bereitstellung von Marktinformationen.

Computer dominieren Börsen

Konrad Sippel, Leiter des Content Labs bei der Deutschen Börse, beschreibt den Börsenhandel von heute: „Da erinnert nichts mehr an die bekannten Szenen von früher, mit Maklern und Brokern, die sich in einem Saal gegenseitig an Preisen und an Lautstärke überbieten. Heute geschieht der allergrößte Teil elektronisch, anonymer und voll automatisiert. Die Börsenteilnehmer sitzen in ihren Büros und an ihren Computern, wobei riesige Datenmengen und Datenströme entstehen. Unser Thema ist daher mittlerweile die Big-Data-Technologie: Wie kann man diese Daten in den Griff bekommen, sie sicher transportieren und so auswerten, dass wir als Deutsche Börse einen Mehrwert dabei erzielen können?“

Die Daten stammen aus unterschiedlichen Quellen und sind in verschiedenen Formaten in teilweise oder komplett unstrukturierten Dateien abgelegt, sodass eine Zusammenführung komplex ist und viel Handarbeit erfordert.

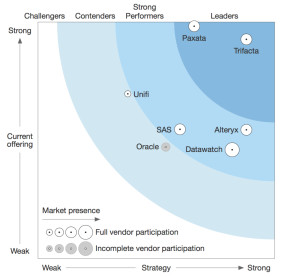

Um hier mehr Effizienz zu erzielen, sah die Deutsche Börse sich nach einer Automatisierungs-Software um. Die Lösung kam aus der amerikanischen Start-up-Welt: Trifacta Wrangler sorgt für eine beschleunigte Aufbereitung all der granularen und zunächst inkompatiblen Daten und versetzt ein Unternehmen wie die Deutsche Börse in die Lage, neue Daten- und Informationsprodukte für eigene Analysezwecke, aber auch für die Anforderungen von Kunden zu entwickeln.Trifacta führt die beiden Welten von Marktexperten und Data Scientists auf der Grundlage einer gemeinsamen integrierten Datenbasis zusammen.

Zum Auswahlprozess erklärt Konrad Sippel: „Am Anfang haben wir einen Proof of Concept (PoC) durchgeführt und Trifacta an einem Business-Case ausprobiert.“ Hierbei ging es um eine Datenbank, die über die Jahre hinweg gewachsen war, mit vielen Daten, „die von der Qualität her sehr schlecht waren – mit vielen Lücken, abweichenden Formatierungen und so weiter“. Man hatte vor dem PoC von einem externen Consultant eine Bereinigung der Daten durchführen lassen. Dabei mussten über einen Zeitraum von neun Monaten hinweg immer wieder Skripte erstellt werden. Sippel erinnert sich: „Den gleichen Prozess haben wir dann mit Trifacta durchgeführt, das Ergebnis sprach für sich – die Skripte wurden automatisch erstellt, das Ganze dauerte nur wenige Wochen.“