Big Data in kleinen und mittleren Unternehmen

Hadoop und die die Apache Software Foundation

von Hartmut Wiehr - 06.10.2014

Es lohnt sich also, sich auf die Erkundung des Open-Source-Terrains für Hadoop-Lösungen einzulassen, wenn selbst Marktführer wie Teradata und andere sich dafür geöffnet haben.

Man muss sich dabei darüber im Klaren sein, woher der Hadoop-Ansatz eigentlich stammt. Alle großen Internetfirmen wie Amazon, Facebook, Google oder Yahoo waren damit konfrontiert, ihre tagtäglich und stündlich hereinströmenden Datenmengen zu erfassen und zu verarbeiten.

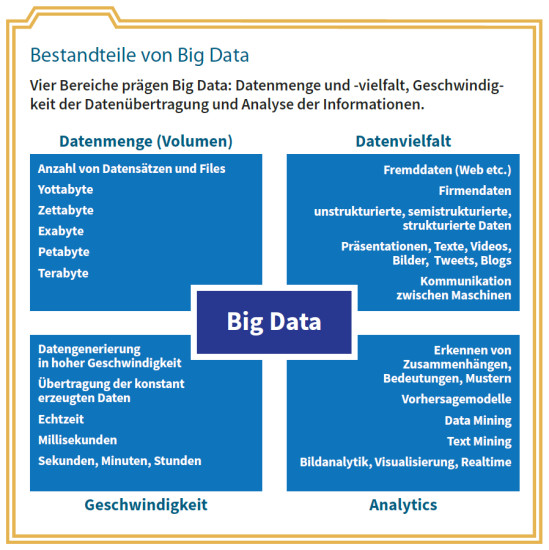

Bestandteile von Big Data: Vier Bereiche prägen Big Data: Datenmenge und -vielfalt, Geschwindigkeit der Datenübertragung und Analyse der Informationen.

(Quelle: com! professional / Bitkom)

Der Anstoß zu Neuentwicklungen kam daher von diesen Internetunternehmen, die schon bei der Hardware-Ausstattung ihrer Rechenzentren auf kostengünstige Standard- und Speichergeräte gesetzt hatten. Die Entwicklung durch eine Community von Softwarespezialisten ermöglichte darüber hinaus, die Applikationen in unterschiedlichen Unternehmen einzusetzen, zu testen und zu verbessern. Um die Professionalität und Unabhängigkeit der Software-Entwicklung zu gewährleisten, kam es zu verschiedenen Ausgründungen, die dem gesamten Markt zur Verfügung stehen sollten. So ist der Hadoop-Spezialist Horton Works aus Yahoo hervorgegangen.

Die Entwicklung von Hadoop wird durch die Apache Software Foundation und ihre Mitglieder vorangetrieben. Hadoop ist heute schon fast ein Synonym für Big Data geworden, weil es Applikationen auf großen Clustern von Standard-Hardware eine kontinuierliche Scale-out-Architektur zur Verfügung stellt. Hadoop benutzt dabei einen Algorithmus namens Map-Reduce, der eine Applikation in viele kleine Fragmente unterteilt, die auf jedem beliebigen Cluster-Node lauffähig sind.

Zusätzlich bietet Hadoop das verteilte File-System HDFS (Hadoop Distributed File System), das Daten auf den Netzknoten speichert und über eine große Bandbreite verfügt. Map-Reduce und HDFS sind beide in der Lage, beim Crash einzelner Nodes automatisch die Daten über das Netzwerk zu verteilen.

Im Rahmen der Hadoop-Umgebung gibt es zahlreiche weitere interessante Tools, zum Beispiel die Programmiersprache R für statistische Zwecke, die ebenfalls frei verfügbar ist, oder Visualierungssoftware für die Performance von Algorithmen (Confusion Matrix).

Spezialisten im eigenen Haus

Man muss nicht gleich seltene (und teure) Datenanalyse-Spezialisten anheuern, um Big-Data- und Analytics-Verfahren sinnvoll einzusetzen. Es geht auch anders: indem man zunächst einen oder mehrere IT-Mitarbeiter auf Fortbildungsveranstaltungen schickt oder – noch günstiger – ihnen Zeit für die Beschäftigung mit den zahlreichen Kursen gibt, die inzwischen im Internet zu Big Data angeboten werden.

Nicht übersehen sollte man dabei, dass spezielle Fachkenntnisse bei der Anwendung von Big-Data-Technologien mit der Zeit weniger nötig sein werden, da die Anbieter immer mehr Automatisierung in ihre Programme hineinpacken – etwa nach dem Vorbild von Firewall-Appliances, die inzwischen für Implementierung und Anwendung auch kein Expertenwissen in Sachen Security mehr voraussetzen.