Netzwerkarchitekturen

Fog-Computing treibt die Cloud voran

von

com!

professional - 18.04.2017

Foto: Ollyy / Shutterstock.com

Fog-Infrastrukturen verbinden lokale Kapazitäten mit Cloud-Ressourcen und eignen sich dank geringer Latenzen etwa für Entwicklungen wie das Internet der Dinge.

Dieser Artikel wurde von Roger Semprini verfasst, Managing Director beim Rechenzentrums-Provider Equinix Schweiz.

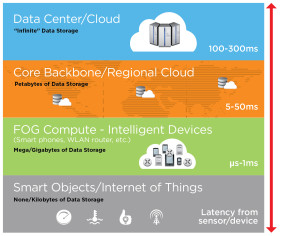

Der Unterschied zwischen Wolken und Nebel? Nebel tritt in Bodennähe auf, Wolken schweben weit entfernt am Himmel. Analog zu Cloud-Computing hat Cisco bereits 2013 den Begriff Fog-Computing geprägt. Damit ist aber nicht nur gemeint, dass Verarbeitungsressourcen lokal platziert sind – das gibt es schon länger. Vielmehr definiert sich Fog-Computing durch seine Fähigkeit zu hybriden Verarbeitungs- und Analytikprozessen, die lokale, standortnahe, zentrale Kapazitäten ebenso einschließen können wie Cloud-Ressourcen.

Mit Fog-Computing rücken Daten- und Rechenressourcen näher zusammen. Digital erfasste und gespeicherte Informationen werden nicht mehr vollständig im Rechenzentrum oder in der Cloud verarbeitet, sondern grundlegende Verarbeitungsschritte finden bereits an ihrem Entstehungsort beziehungsweise in dessen unmittelbarer Nähe statt. So lassen sich Effizienz-, Leistungs-, Sicherheits- und Kostenvorteile realisieren. Allerdings ist hierfür eine Standort- und Netzwerkarchitektur notwendig, die sich von traditionellen Infrastrukturen unterscheidet. Fog-Computing tritt nicht in Konkurrenz zur Cloud, sondern ist vielmehr eine Weiterentwicklung.

Gründe für Fog-Computing

In den meisten Unternehmen sind Workloads, Daten und Anwendungen zentral in Rechenzentren und mittlerweile auch in der Cloud platziert, wobei unterschiedliche Clients an diversen Standorten darauf zugreifen. Alle maßgeblichen Rechenfunktionen erfolgen also im Datacenter oder in der Cloud, die Clients initiieren nur die notwendigen Datentransfers über das Netzwerk und erhalten die Ergebnisse zurück. Diese Architektur hat den Vorteil, dass es einfach ist, die Applikationen und die Zugriffe zu managen sowie die Server- und Netzwerkauslastung zu optimieren.

Allerdings führen Trends wie das Internet der Dinge dazu, dass immer umfangreichere Datenvolumina an sehr vielen, geografisch verteilten Endpunkten entstehen. Um diese zu sammeln, zu verarbeiten und zu analysieren, ist es häufig ineffektiv, die gesamten Daten über das Netzwerk zu den zentralen Verarbeitungsstandorten zu transferieren. Die Netzwerkkosten steigen, mit jedem Netzwerk-Hop sinkt das Sicherheitsniveau, zudem summieren sich die Latenzen.

Es ist daher logisch, die Verarbeitungsintelligenz näher an die Endpunkte zu rücken, an denen die Daten entstehen. Im Idealfall erfolgen die grundlegende Verarbeitung und eine Konsolidierung schon direkt am Sensor, der die Daten erzeugt. Meist ist es jedoch praktikabel, Daten in nahe bei den Endpunkten gelegenen Standorten oder Clouds zu verarbeiten. In beiden Fällen werden danach nur relevante Daten an die zentralen entfernten Verarbeitungsressourcen im Rechenzentrum oder in der Cloud übertragen.